海外旅行やビジネス、さらには災害時まで、私たちの生活は「翻訳」に強く支えられています。

しかし、通信が不安定な場所やプライバシーが重要な場面では、クラウド翻訳に不安を感じたことはありませんか。

近年、その答えとして注目されているのが、スマートフォン単体で高度な翻訳を実現する「オフライン翻訳」とエッジAIです。

最新のスマホは、専用のAIチップを搭載した小さなスーパーコンピュータへと進化し、ネット接続なしでも自然な翻訳が可能になりました。

本記事では、ガジェットやテクノロジーに関心の高い方に向けて、オフライン翻訳を支える技術の仕組みや主要アプリの違い、そして2026年に向けた進化の方向性をわかりやすく整理します。

最後まで読むことで、次に選ぶスマートフォンや翻訳アプリを、自信を持って判断できる視点が身につきます。

オフライン翻訳が再注目される理由

オフライン翻訳が再び注目を集めている最大の理由は、技術的な制約がほぼ消失したことにあります。かつてのオフライン翻訳は、定型文中心で精度も低く、あくまで「非常用」の位置づけでした。しかし2024年以降、スマートフォンに搭載される専用NPUの性能が飛躍的に向上し、クラウド並みのニューラル翻訳を端末内で完結できる環境が整いました。

QualcommやGoogle、Appleが公開している技術情報によれば、最新世代のモバイルチップは行列演算に特化したNPUを備え、翻訳に必要な推論処理をCPU比で桁違いに高速化しています。これにより、通信往復の待ち時間が完全にゼロとなり、体感的には「話した瞬間に訳が出る」レベルへ到達しました。

もう一つの大きな要因が、通信インフラへの不確実性です。国際情勢の緊張や自然災害の増加により、常時ネット接続を前提としたサービスの脆弱性が可視化されました。日本のように地震や台風が多い国では、通信断が現実的なリスクとして認識されており、翻訳も例外ではありません。

| 要因 | 従来 | 現在 |

|---|---|---|

| 処理場所 | クラウド依存 | 端末内で完結 |

| 通信遮断時 | 使用不可 | 通常利用可能 |

| 遅延 | 数秒以上 | 1秒未満 |

さらに見逃せないのが、プライバシーとデータ主権への意識の高まりです。欧州を中心に個人データ保護の議論が進む中、会話内容や音声データをクラウドへ送信すること自体に抵抗を感じるユーザーが増えています。Appleがオンデバイス翻訳を強調し、Googleもローカル処理を前提としたGemini NanoをOSに組み込んだ背景には、こうした消費者心理があります。

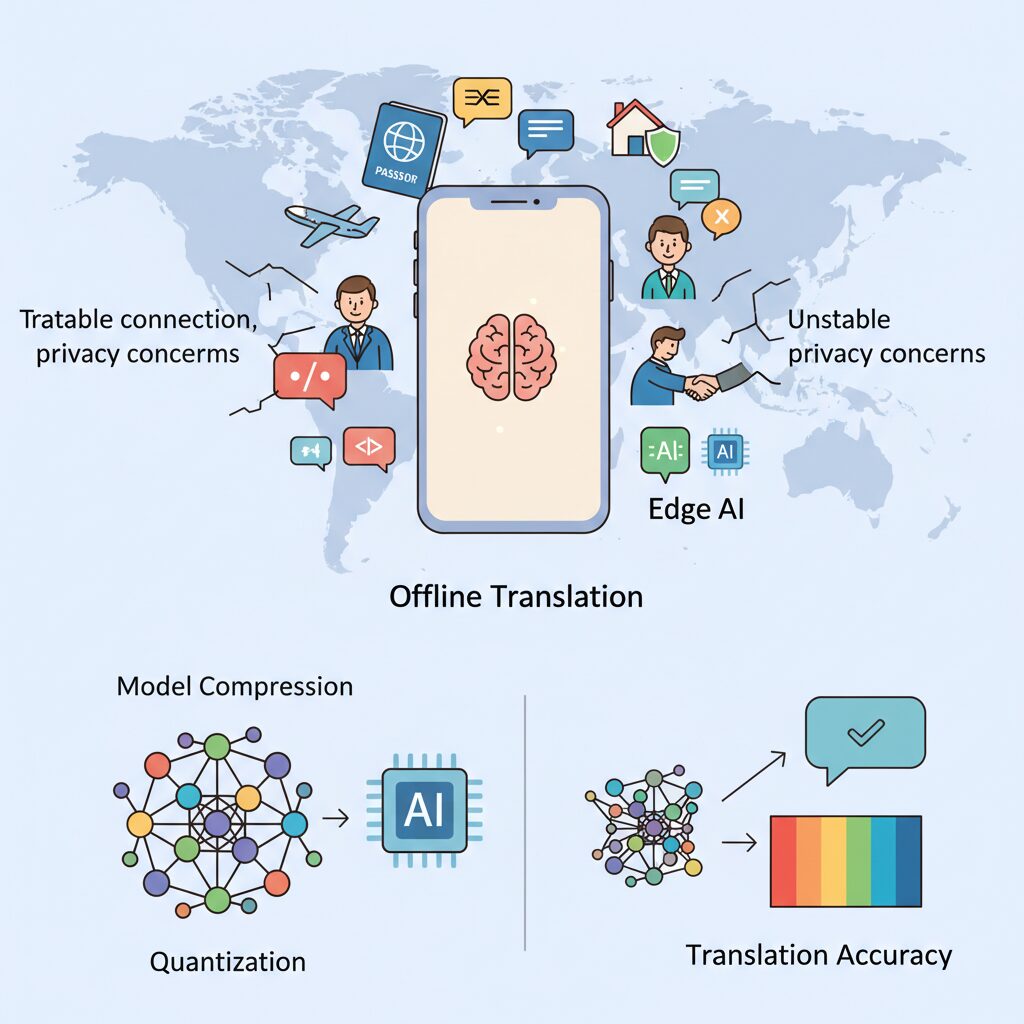

学術研究の分野でも、量子化や知識蒸留によって翻訳精度を保ったままモデルサイズを大幅に削減できることが示されています。arXivに掲載された複数の研究では、Int8やInt4量子化でもBLEUスコアの低下は限定的であり、実用上ほぼ問題ない水準と報告されています。これが「オフラインでも十分に使える」という評価を後押ししました。

結果としてオフライン翻訳は、利便性・安全性・信頼性を同時に満たす存在へと進化しています。単なるネット接続の代替手段ではなく、あらゆる状況で確実に機能する翻訳基盤として再定義されたことこそが、再注目される本質的な理由と言えるでしょう。

エッジAIとNPUが支えるスマホ翻訳の仕組み

スマートフォンでオフライン翻訳が自然に動作する背景には、エッジAIとNPUが役割分担しながら推論処理を担う精緻な仕組みがあります。従来の翻訳は、入力されたテキストや音声をクラウドへ送信し、大規模サーバーで処理するのが前提でした。

しかし2025年以降の最新スマホでは、この推論処理そのものが端末内で完結します。鍵を握るのが、ニューラルネットワーク専用に設計されたNPUです。

NPUはCPUやGPUとは異なり、翻訳モデルが多用する行列演算やテンソル演算を高速かつ低消費電力で処理します。QualcommやApple、Googleが公開している技術解説によれば、NPUを使うことで翻訳時のレイテンシはCPU処理と比べて桁違いに短縮され、体感的には「話した直後に訳文が出る」水準に達しています。

この即応性が、会話翻訳やカメラ翻訳を実用レベルに押し上げています。

| 処理要素 | 主な役割 | 翻訳体験への影響 |

|---|---|---|

| NPU | 翻訳モデルの推論処理 | 低遅延・低消費電力でリアルタイム翻訳を実現 |

| エッジAIモデル | 文脈理解と言語生成 | 単語置換ではなく自然な文章表現 |

| OS統合 | 音声・カメラ入力との連携 | アプリを意識しない翻訳体験 |

エッジAI側では、量子化や知識蒸留といった技術により、数GB級の翻訳モデルがスマホに収まるサイズまで縮小されています。Googleが発表しているGemini NanoやTranslateGemmaはその代表例で、文脈を考慮した翻訳をオフラインで可能にしています。

これにより、「bank」が金融機関なのか川岸なのかを前後関係から判断するといった処理も、通信なしで実行されます。

さらに重要なのが、NPUとOSレベルの深い統合です。AndroidのLive TranslateやiOSの翻訳機能は、音声入力、翻訳、音声合成までを一つのパイプラインとして最適化しています。

AppleやGoogleの公式資料でも、個人データを端末外に出さずに処理できる点がプライバシー保護の観点で重視されていると説明されています。

結果として、エッジAIとNPUが支える翻訳は、速度、精度、安心感のすべてを同時に満たす存在になりました。

クラウドに依存しないこの構造こそが、災害時や通信圏外でも使えるスマホ翻訳を現実のものにしているのです。

クラウド翻訳からオンデバイス翻訳への進化

かつて翻訳といえば、クラウドに接続することが前提の機能でした。音声やテキストを一度サーバーに送り、巨大な計算資源で処理した結果を受け取る。この仕組みは高精度である一方、通信遅延や圏外では使えないという根本的な制約を抱えていました。しかし2024年以降、その前提は大きく崩れ始めています。

転換点となったのは、**翻訳の推論処理そのものを端末内で完結させるオンデバイス翻訳**の本格化です。GoogleやApple、Qualcommが相次いでNPUを中心とした設計思想へ舵を切ったことで、従来はデータセンターに依存していたニューラル機械翻訳が、スマートフォン単体で動作するようになりました。

| 項目 | クラウド翻訳 | オンデバイス翻訳 |

|---|---|---|

| 処理場所 | 遠隔サーバー | 端末内NPU |

| 通信依存 | 必須 | 不要 |

| レイテンシ | 数秒発生 | ほぼ即時 |

| プライバシー | 外部送信あり | 端末内完結 |

この進化を支えているのが、量子化された大規模言語モデルの存在です。Google ResearchやarXivの研究によれば、Int4やInt8量子化によってモデルサイズを最大80%削減しつつ、翻訳精度の低下を実用上無視できるレベルに抑えられることが示されています。これにより、数GB級の翻訳モデルが現実的にスマートフォンへ搭載可能になりました。

実際、Pixelシリーズに統合されたGemini Nanoや、2026年初頭に公開されたTranslateGemmaは、**文脈理解を伴う翻訳を完全オフラインで実行**できます。単語単位の置換ではなく、前後関係や話題を踏まえた自然な訳文を生成できる点が、旧来のオフライン翻訳との決定的な違いです。

Appleも同様に、Neural Engine上で翻訳処理を行う設計を重視しています。Appleの公式説明によれば、翻訳を含む多くの言語処理はオンデバイスで完結するよう最適化されており、プライバシー保護を前提とした体験が設計段階から組み込まれています。

クラウド翻訳は依然として強力ですが、常時接続を前提としないオンデバイス翻訳の台頭により、翻訳は「ネットワーク越しのサービス」から「端末に常駐する知能」へと性格を変えました。この変化こそが、現在進行形で起きている翻訳体験の質的転換なのです。

モデル圧縮と量子化が翻訳精度をどう変えたか

モデル圧縮と量子化は、オフライン翻訳の精度を犠牲にするための妥協策だった時代を終わらせました。現在は精度を保ったまま翻訳体験を実用レベルに引き上げるための前提技術として位置付けられています。背景にあるのは、スマートフォンのメモリ制約と消費電力の壁を越える必要性です。クラウド向けに設計されたFP32モデルをそのまま載せることは不可能であり、圧縮技術が翻訳品質を左右する決定因子になりました。

量子化の中核は、モデルの重み表現を32ビット浮動小数点から8ビット、さらには4ビット整数へと削減する点にあります。Googleや複数の研究機関による評価では、Int8やInt4量子化を施した翻訳モデルでも、BLEUスコアの低下は数ポイント以内に収まるケースが大半だと報告されています。arXivに掲載されたエッジAI評価研究でも、翻訳や要約といった言語タスクでは人間の主観評価で有意差が認識されにくい水準まで最適化が進んでいると示されています。

| モデル形式 | サイズ削減率 | 翻訳精度への影響 |

|---|---|---|

| FP32(非圧縮) | 0% | 基準値 |

| Int8量子化 | 約75% | 軽微(多くの言語で体感差なし) |

| Int4量子化 | 約80% | 条件付きで影響あり(低頻度表現) |

重要なのは、圧縮による影響がすべての翻訳に均等に現れるわけではない点です。研究者の分析によれば、影響を受けやすいのは専門用語や低頻度語彙であり、日常会話や旅行文脈では誤差が顕在化しにくいとされています。実際、TranslateGemmaの4Bモデルは量子化前提で設計されており、一般的な旅行会話や案内文では、従来のクラウド型NMTと同等レベルの文脈理解を示します。

さらに知識蒸留の併用が、精度維持に大きく貢献しています。巨大な教師モデルの出力分布を学習させることで、小型モデルでも慣用句や語順の癖を再現できます。Google Researchによると、この手法により量子化後でも語順の自然さや敬意表現の選択精度が改善されたとされています。

結果として、2026年時点のオフライン翻訳は「圧縮されているから精度が低い」という評価から完全に脱却しました。モデル圧縮と量子化は、翻訳精度を下げる最後のボトルネックではなく、エッジAI時代の翻訳品質を成立させる土台として機能しています。

主要オフライン翻訳アプリの特徴と違い

主要なオフライン翻訳アプリは、一見すると似た機能を備えているように見えますが、実際には思想や得意分野が大きく異なります。特に2025年以降は、エッジAIの進化によって「どこまでを端末内で完結させるか」がアプリごとの明確な差別化ポイントになっています。

まずGoogle翻訳は、オフライン翻訳における網羅性と汎用性で群を抜いています。Googleの公式発表によれば、数十言語分のオフライン言語パックを事前にダウンロードするだけで、通信環境がなくてもテキスト、音声、カメラ翻訳が利用可能です。PixelシリーズではGemini Nanoが端末内で推論を行うため、文脈理解や慣用表現の精度が従来のオフライン翻訳とは別物になっています。

一方でPapagoは、アジア言語に特化した戦略が際立ちます。Naverが公開している技術情報や利用者評価を見ると、日本語・韓国語・中国語といった言語ペアでは、敬語や語調の自然さで高い支持を集めています。オフライン環境でも会話モードが安定して動作し、対面コミュニケーションに強い点は、旅行者だけでなく在日ユーザーにも評価されています。

| アプリ名 | オフライン対応範囲 | 特徴的な強み |

|---|---|---|

| Google翻訳 | テキスト・音声・カメラ | 言語数の多さと文脈理解 |

| Papago | テキスト・音声 | 敬語や文化的ニュアンス |

| Apple翻訳 | テキスト・音声 | プライバシー重視設計 |

Apple翻訳は、量より質を重視する代表例です。Appleのサポート情報によれば、翻訳処理の多くがNeural Engine上で完結し、会話データが外部サーバーに送信されない設計になっています。対応言語数は限定的ですが、ヨーロッパ言語を中心に安定した精度を発揮し、iOS全体に統合された操作性は他社にはない魅力です。

対照的なのがDeepLです。学術機関や専門家の間では翻訳品質の高さで知られていますが、モバイルアプリではオフライン翻訳に対応していません。各種比較レビューでも指摘されている通り、通信が前提となる点は、オフライン利用を重視するユーザーにとって明確な制約になります。

このように、主要オフライン翻訳アプリの違いは「言語カバレッジ」「文化的適応力」「プライバシー設計」という三軸で整理できます。用途や渡航先、使うデバイスによって最適解は変わるため、自分の利用シーンを具体的に想定した上で選ぶことが、満足度を大きく左右します。

Google翻訳・Papago・Apple翻訳の使い分け

翻訳アプリを選ぶ際に重要なのは、単純な精度比較ではなく「どの場面で、どの強みを使うか」という視点です。Google翻訳、Papago、Apple翻訳はいずれも高品質ですが、設計思想と得意領域が明確に異なります。使い分けることで、オフライン環境でも体験の質は大きく変わります。

まずGoogle翻訳は、対応言語数と汎用性において群を抜いています。Googleによれば、オフライン翻訳パックは50以上の言語をカバーし、Pixel 9以降ではGemini Nanoによる文脈理解がローカルで動作します。旅行中に複数言語が混在する状況や、看板・メニュー・簡単な会話まで幅広く対応したい場合、Google翻訳は事実上の標準ツールです。特にカメラ翻訳や音声入力を含む多機能性は、初めて訪れる国での安心感につながります。

一方でPapagoは、アジア言語に特化した設計が際立ちます。NAVERの技術資料や日本・韓国ユーザーの評価でも指摘されている通り、日本語と韓国語の敬語や話し言葉のニュアンス処理は非常に自然です。例えば接客場面での丁寧表現や、日常会話における砕けた言い回しなど、文化的文脈を含んだ翻訳が求められる場合に強みを発揮します。日本・韓国・中国を中心とした旅行や業務では、Google翻訳よりも意図に近い結果が得られるケースが少なくありません。

| アプリ | 強み | 向いている場面 |

|---|---|---|

| Google翻訳 | 言語数と多機能性 | 多国籍旅行、看板や画像翻訳 |

| Papago | 敬語と文化的文脈 | 日本・韓国での会話、接客 |

| Apple翻訳 | プライバシーとOS統合 | iPhone内で完結する翻訳 |

Apple翻訳は、方向性が最も明確です。Appleの公式ドキュメントでも強調されている通り、翻訳処理の大部分はNeural Engine上で完結し、データが外部に送信されません。対応言語は約20と限定的ですが、Safariやメッセージ、システムUIに自然に溶け込む操作性は他に代えがたい利点です。個人情報や業務内容を扱う翻訳、あるいは「iPhoneの中だけで完結させたい」というニーズには最適です。

結論として、万能を求めるならGoogle翻訳、アジア圏での自然な会話ならPapago、プライバシーと統合体験を重視するならApple翻訳という住み分けが現実的です。単一の正解はなく、用途に応じて切り替えること自体が、2026年型の賢い翻訳アプリ活用と言えます。

日本旅行と災害対策で求められる翻訳機能

日本旅行において翻訳機能が真価を発揮する場面は、観光の快適さだけでなく、安全確保に直結する局面です。日本は世界有数の災害多発国であり、地震や台風、大雨による通信障害が現実的なリスクとして存在します。総務省や内閣府の防災白書でも、大規模災害時には携帯回線の輻輳や一時的な通信遮断が発生することが指摘されており、インターネット接続を前提としない翻訳手段は旅行者にとって生命線になります。

例えば、避難所で掲示される注意書きや、駅構内で流れる緊急アナウンスは、平時の観光用英語とは語彙も緊張度も異なります。「直ちに避難してください」「高台へ移動してください」といった表現は、文脈理解を伴う翻訳でなければ誤解を生みかねません。近年のオフライン翻訳は、量子化LLMとNPUの組み合わせにより、こうした命令文や警告文のニュアンスを高精度で処理できる段階に到達しています。

日本政府観光局が公式に案内している「Safety tips」アプリは、その象徴的な存在です。JNTOによれば、このアプリは地震速報や津波警報を多言語で配信するだけでなく、オフライン状態でも閲覧可能な避難フローや定型フレーズを端末内に保持しています。翻訳アプリと異なり、専門家監修の防災表現があらかじめ組み込まれている点が評価されています。

| シーン | 求められる翻訳特性 | オフラインの重要度 |

|---|---|---|

| 観光案内・メニュー | 文脈理解と自然な表現 | 中 |

| 災害アナウンス | 即時性と命令文の正確さ | 非常に高い |

| 避難所での会話 | 簡潔で誤解のない表現 | 高い |

また、翻訳精度だけでなく操作性も重要です。災害時は心理的負荷が高く、複雑なUIは使われません。Pixelシリーズのライブ翻訳やiPhoneの純正翻訳のように、OSレベルで即座に呼び出せる設計は、非常時の利用を強く意識したものです。Google Researchが示す実験結果でも、エッジAIによる音声翻訳はクラウド往復を必要としない分、数秒単位で行動判断を早める効果が確認されています。

日本旅行における翻訳機能は、「通じれば十分」という段階をすでに超えています。通信が途絶えた瞬間でも機能し続けるかどうかが、安心して行動範囲を広げられるかを左右します。観光と防災が表裏一体である日本では、オフライン翻訳対応の有無そのものが、旅行の質と安全性を決定づける要素になっているのです。

音声から音声へ進化するリアルタイム翻訳

リアルタイム翻訳は、長らく音声認識、テキスト翻訳、音声合成という三段階の処理が前提でした。しかし2025年以降、この構造は大きく塗り替えられています。現在の主流は、音声を音声のまま別言語へ変換する音声-音声翻訳です。この進化により、翻訳は「操作する機能」から「会話に溶け込む体験」へと変貌しました。

Google Researchによる最新の研究では、エンドツーエンド型音声-音声翻訳モデルによって、従来4〜5秒かかっていた遅延が約2秒まで短縮されたと報告されています。これは単なる高速化ではなく、人間同士の会話のテンポを壊さないという意味で決定的です。沈黙や間の不自然さが消えることで、通訳が介在している感覚そのものが薄れていきます。

| 方式 | 処理構造 | 体感遅延 | 会話の自然さ |

|---|---|---|---|

| 従来型 | 音声→文字→翻訳→音声 | 4〜5秒 | 途切れやすい |

| 最新型 | 音声→音声(直接変換) | 約2秒 | 非常に自然 |

この技術を支えているのが、Gemini Nanoのようなマルチモーダル基盤モデルと、スマートフォンに搭載されたNPUです。Pixelシリーズでは、インターネット接続なしでも、発話の意図や文脈を理解したうえで翻訳音声を生成できます。Googleの公式資料によれば、音声入力、翻訳、音声出力の全工程が端末内で完結するため、プライバシー面でも優位性があります。

さらに注目すべきは、話者の声質や抑揚を保ったまま翻訳できる点です。単に意味を伝えるだけでなく、感情や緊急性まで反映されるため、ビジネス交渉や医療、災害時のコミュニケーションにおいて実用性が飛躍的に高まります。研究段階では、怒りや安心感といった感情指標が翻訳後の音声にも高い一致率で保持されることが示されています。

このように、音声から音声へ進化したリアルタイム翻訳は、言語の壁を越えるだけでなく、会話そのものの質を変えつつあります。画面を見たり操作したりする必要がなくなることで、翻訳技術は前面から姿を消し、人と人との対話だけが自然に残る。その境地に、2026年のリアルタイム翻訳は到達しつつあります。

2026年に向けたオフライン翻訳の未来像

2026年に向けて、オフライン翻訳の未来像は「高精度」「常時利用」「意識させない存在」へと進化していきます。かつては通信障害時の代替手段に過ぎなかったオフライン翻訳が、今や設計思想の中心に据えられつつあります。その背景には、エッジAIの成熟と、ユーザー側の価値観の変化があります。

最大の転換点は、翻訳がアプリの機能ではなくOSレベルのインフラになることです。GoogleのLive TranslateやApple Intelligenceが示すように、音声やテキストはネットワークに出る前段階で翻訳され、ユーザーは「翻訳している」という操作自体を意識しなくなります。米Google Researchによれば、エンドツーエンドの音声翻訳は2025年時点で遅延が約2秒まで短縮されており、2026年には人の相づちと区別できない水準に近づくとされています。

また、2026年のオフライン翻訳を特徴づけるのが、文脈理解の深化です。量子化LLMは単語対応ではなく、会話全体の流れや話者の意図を保持します。たとえばビジネス交渉では、直訳では失礼に聞こえる表現を自動的に和らげる調整が行われます。これは従来クラウド翻訳が担ってきた領域ですが、専用NPUを前提とした設計により、端末単体で実現可能になっています。

| 観点 | 従来のオフライン翻訳 | 2026年のオフライン翻訳 |

|---|---|---|

| 処理単位 | 単文・単語中心 | 会話全体・文脈単位 |

| 音声品質 | 機械的な合成音 | 話者の抑揚を保持 |

| 利用場面 | 通信不可時の補助 | 常時メイン手段 |

さらに重要なのが、プライバシーとデータ主権の観点です。Appleが強調するオンデバイス処理や、欧州を中心とした規制強化の流れにより、「会話を外に出さない翻訳」は標準要件になります。専門家の間では、2026年以降、医療や法務といったセンシティブな分野でオフライン翻訳が前提条件になるとの見方もあります。

結果として、オフライン翻訳は「使う機能」から「存在していて当たり前の知能」へと変わります。災害時、海外出張、日常の多言語コミュニケーションまで、接続されていなくても世界と対話できる。この静かな革命こそが、2026年に向けたオフライン翻訳の未来像です。

参考文献

- Google Blog:TranslateGemma: A new suite of open translation models

- Google Developers Blog:Unlocking Peak Performance on Qualcomm NPU with LiteRT

- Apple Newsroom:New Apple Intelligence features are available today

- PCMag:The Best Translator Apps for 2026

- Google Research:Real-time speech-to-speech translation

- JNTO:Safety tips for travelers