生成AIやスマートデバイスが急速に進化する一方で、「このAIは海外規制に対応できているのか」と不安を感じたことはありませんか。

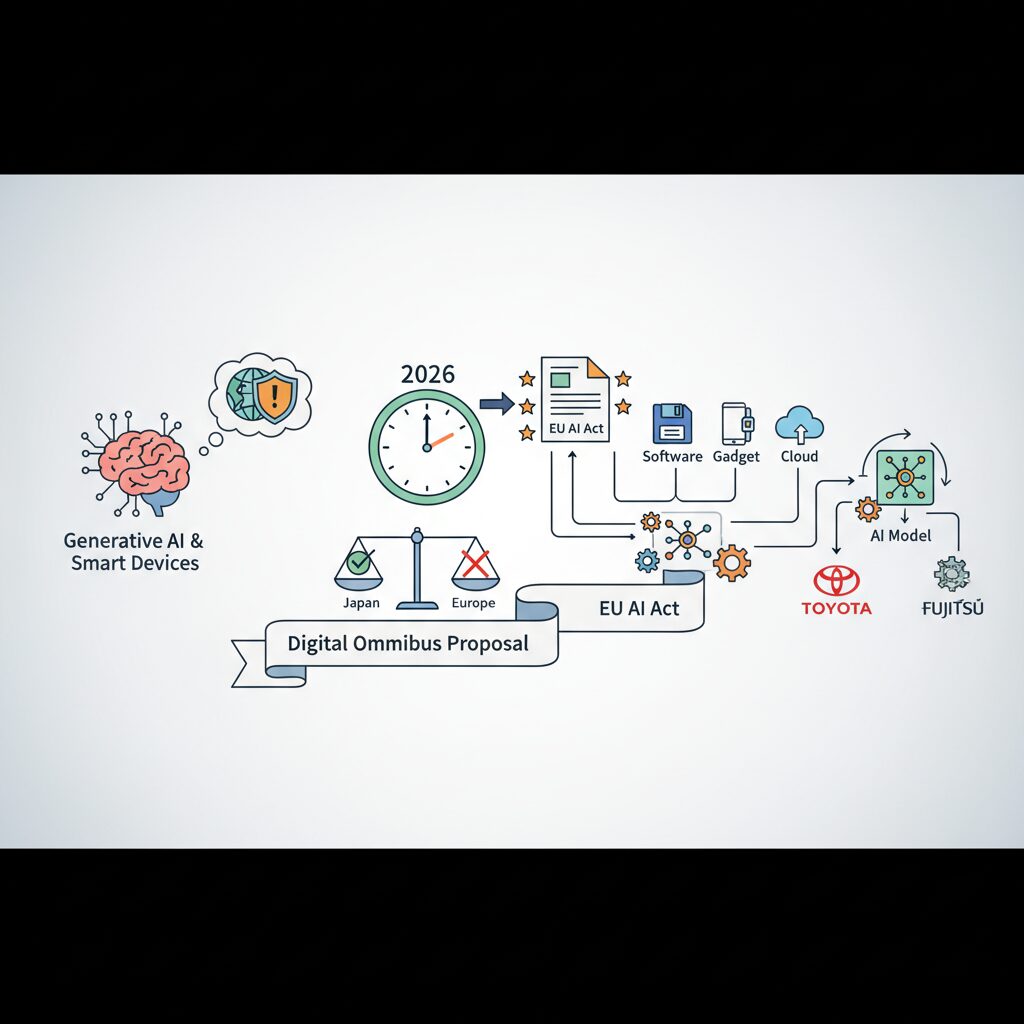

2026年に本格施行されるEU AI法(EU AI Act)は、ソフトウェア、ガジェット、クラウド、AIモデルを扱う企業や開発者にとって、無視できない世界標準になりつつあります。特に日本企業にとっては、国内では合法でも、欧州市場では違法となるケースが現実的なリスクとして浮上しています。

本記事では、EU AI法の全体像から、デジタル・オムニバス提案によるスケジュール変更、汎用AI(GPAI)への新ルール、そしてトヨタやソニー、富士通など日本企業の具体的な動きまでを整理します。AIや最新テクノロジーに関心のある方が、「今、何を理解し、どう備えるべきか」を体系的につかめる内容をお届けします。

EU AI法とは何か:2026年に世界標準となる理由

EU AI法とは、欧州連合が策定した世界初の包括的な人工知能規制法であり、AIの開発・提供・利用をリスクベースで体系的に管理する枠組みです。最大の特徴は、倫理指針や自主ルールにとどまらず、法的拘束力を持つハード・ローとして設計されている点です。2026年はこのEU AI法が実務レベルで本格的に効力を発揮し、事実上の世界標準として機能し始める転換点になります。

EU AI法では、AIを「禁止」「高リスク」「限定リスク」「最小リスク」に分類し、用途ごとに義務の重さを変えています。たとえば社会的スコアリングや特定の感情認識AIは原則禁止とされる一方、医療、金融、採用、自動運転など人の権利や安全に重大な影響を与える分野は高リスクAIに分類され、厳格な管理義務が課されます。欧州委員会によれば、この構造は消費者保護とイノベーションの両立を狙ったものです。

| 区分 | 代表例 | 主な扱い |

|---|---|---|

| 禁止AI | 社会的信用スコア | 原則使用不可 |

| 高リスクAI | 医療診断、採用選考 | 厳格な管理義務 |

| 限定リスクAI | 生成AI、チャットボット | 透明性義務 |

この法律が2026年に世界標準となる最大の理由は、いわゆるブリュッセル効果にあります。EU市場は巨大であり、EU域内でAIを提供・利用する企業は、たとえ日本企業や米国企業であってもEU AI法への準拠が不可欠です。その結果、グローバル企業は二重対応を避けるため、最も厳しいEU基準を全世界の製品設計やガバナンスに採用する傾向が強まっています。

実際、欧州委員会AIオフィスが2025年に稼働を開始し、生成AIを含む汎用AIモデルに対する規制はすでに段階的に適用されています。トヨタ、ソニー、富士通、NECといった日本の大手企業がEUの自主誓約プログラムであるAIパクトに参加していることは、EU AI法が単なる地域規制ではなく、国際ビジネスの前提条件になりつつある現実を示しています。

さらに重要なのは、EU AI法がISOなどの国際標準化とも強く連動している点です。CENやCENELECによる整合規格、ISO/IEC 42001の欧州採用が進むことで、EU AI法は「守らなければならない法律」であると同時に、「世界共通のAI管理モデル」として拡張されています。2026年、EU AI法は規制の枠を超え、信頼できるAIを測るグローバルな物差しとして定着し始めているのです。

デジタル・オムニバス提案がもたらした施行スケジュールの変化

デジタル・オムニバス提案が日本企業に与えた最も大きな影響は、EU AI法の施行スケジュールが固定的な日付管理から、条件連動型へと質的に変化した点にあります。従来は「2026年8月2日」という明確な期限を前提に、逆算型で準備を進める必要がありましたが、2025年11月に欧州委員会が示した新提案により、この前提そのものが揺らぎました。

背景にあるのは、欧州標準化委員会CENおよびCENELECにおける整合規格策定の深刻な遅延です。欧州委員会自身も、規格が存在しないまま法的義務だけを先行させれば、市場に混乱を招くことを認めています。こうした認識のもと導入されたのが、いわゆるストップ・ザ・クロックと呼ばれる動的メカニズムです。

この仕組みでは、高リスクAIシステムに該当するAnnex IIIは、欧州委員会が整合規格や共通仕様の利用可能性を正式に確認した決定から6か月後に適用開始となります。一方、自動車や医療機器など規制対象製品に組み込まれるAI、すなわちAnnex Iは12か月後です。ただし、無期限の先送りではなく、最終期限としてそれぞれ2027年12月、2028年8月という上限が設定されています。

| 区分 | 当初予定 | オムニバス後の考え方 |

|---|---|---|

| 高リスクAI(Annex III) | 2026年8月 | 委員会決定から6か月後 |

| 製品組込みAI(Annex I) | 2026年8月 | 委員会決定から12か月後 |

この変更は、日本の自動車メーカーや医療機器メーカーにとって特に重要です。一般に3年から5年を要する製品開発サイクルと、突発的な規制施行とのミスマッチが緩和される可能性が生まれたためです。欧州委員会の説明資料でも、産業界からの「規格未整備のままでは適合性評価が不可能」という声が強く反映されたとされています。

ただし、この実質延期を単純な猶予と捉えるのは危険です。採択プロセスは欧州議会と理事会を残しており、政治的な修正が入る余地もあります。そのため多くの専門家は、当初の2026年8月を前提にした準備を継続しつつ、延期が確定した場合のリソース再配分を同時に設計する二重のスケジュール管理を推奨しています。

スケジュールが流動化したことで問われているのは、期限対応力ではなく変化耐性です。デジタル・オムニバスは、日本企業に時間を与えた一方で、規制環境を常時モニタリングし続ける体制構築という、より高度な経営判断を突きつけています。

汎用AI(GPAI)規制の核心とCode of Practiceのポイント

EU AI法の中でも、汎用AI(GPAI)規制は最も実務への影響が大きい領域です。2025年8月から既に適用が始まっており、2026年時点では「将来の話」ではなく、日々の開発・提供プロセスそのものが規制対象になっています。ここで中核となるのが、欧州委員会AIオフィス主導で策定されたCode of Practiceです。

この実務規範は法律本文を補完するソフトローですが、実質的にはコンプライアンスの設計図として機能しています。欧州委員会によれば、約1,000の企業・研究機関・市民団体が議論に参加しており、単なる理念ではなく、監督・執行を前提とした内容になっています。

| 柱 | 主な要求内容 | 日本企業への意味 |

|---|---|---|

| 透明性 | モデル文書化、学習データ概要、計算資源の説明 | 独自LLMやAPI提供時に技術情報整理が必須 |

| 著作権 | TDMオプトアウト尊重、robots.txt遵守 | 日本法との違いが最大の摩擦点 |

| システミックリスク | レッドチーミング、重大インシデント報告 | 大規模学習を行う企業は将来的に対象 |

特に注意すべきは著作権の扱いです。日本の著作権法では情報解析目的の利用が広く認められていますが、EUでは権利者が明示的に拒否したデータの学習利用は許されません。欧州委員会の解釈では、学習段階での違反も市場提供時に問題視され得るとされており、日本で合法に作ったモデルがEUでは違法になるという事態が現実的に起こります。

もう一つの核心は、GPAIの責任主体の考え方です。欧州委員会のガイドラインでは、既存モデルをファインチューニングしただけでも、性能やリスク特性が大きく変われば新たな「プロバイダー」と見なされる可能性が示されています。これはSIerやスタートアップにとって見落としがちな落とし穴であり、「元モデルは海外製」という説明は免責になりません。

欧州委員会や有力法律事務所の分析によれば、実務規範に沿った対応をしているかどうかが、将来の調査や制裁判断で重要な考慮要素になるとされています。つまり、GPAI規制の本質は「罰則」よりも、開発段階から説明可能で責任あるAIを組み立てているかという姿勢そのものにあります。

ガジェットやソフトウェアに関心の高い読者にとって重要なのは、この規制がイノベーションを止める壁ではなく、信頼を前提にした市場参加の入場券になりつつある点です。Code of Practiceを理解することは、欧州市場でAIを使うための最低限のリテラシーになっています。

生成AIと著作権:日本法との決定的な違い

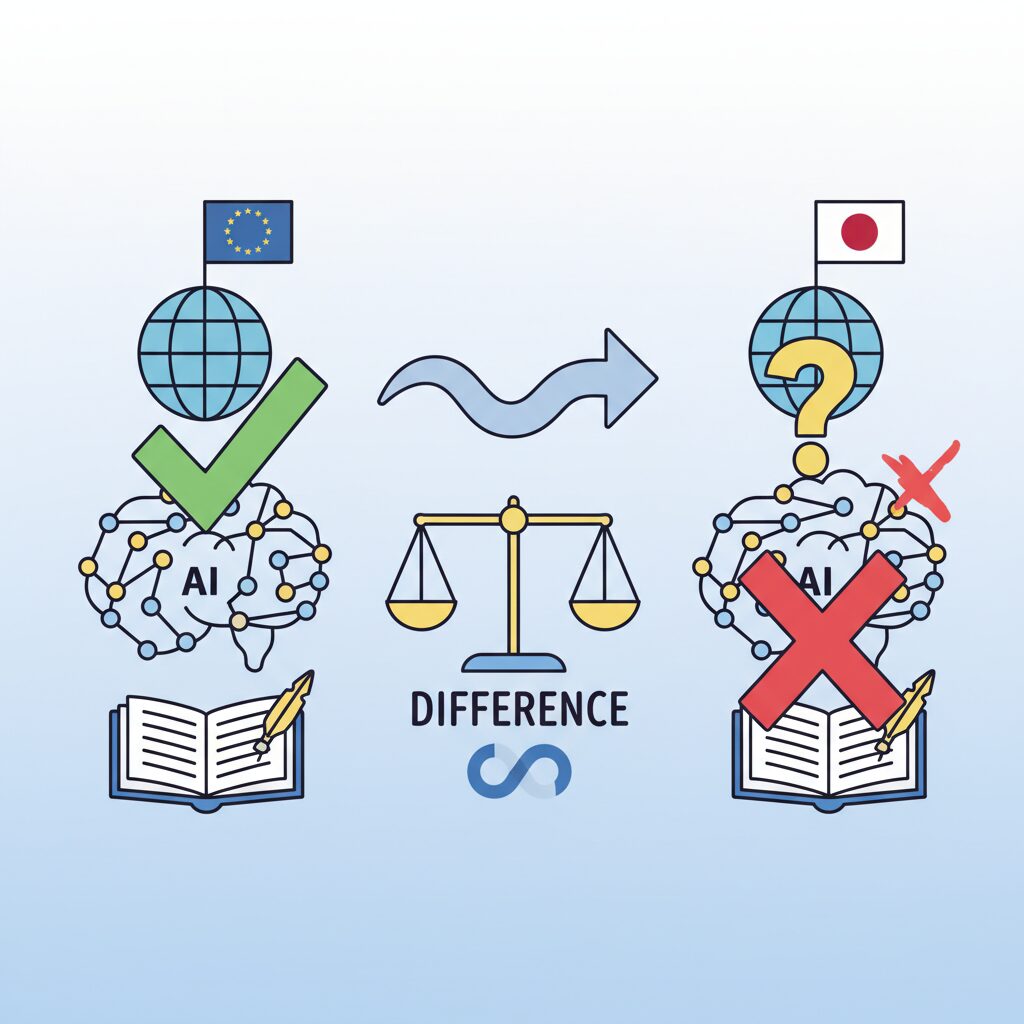

生成AIと著作権を巡る議論で、日本法とEU法の違いは決定的です。最大の分岐点は「AI学習に著作物を使ってよいかどうか」を誰がコントロールするのかという点にあります。

日本の著作権法は第30条の4により、情報解析を目的とする場合、営利・非営利を問わず、原則として権利者の許諾なく著作物を利用できます。文化庁の解釈でも、機械学習は典型的な情報解析に該当すると整理されています。

その結果、日本では「学習段階」と「生成物の利用段階」を明確に分離して考える実務が定着しました。学習自体は適法、問題は生成結果が既存著作物と類似しすぎていないか、という整理です。

| 観点 | 日本法 | EU法 |

|---|---|---|

| 学習時の許諾 | 原則不要 | 権利者のオプトアウト尊重 |

| 法的性質 | 明文規定あり | 著作権指令とAI法が連動 |

| 企業リスク | 生成物中心 | 学習プロセス自体が対象 |

一方EUでは、DSM著作権指令第4条に基づき、テキスト・データ・マイニングは原則可能としつつも、権利者が拒否の意思を示した場合はそれを尊重する義務があります。EU AI法の実務規範では、このオプトアウトを技術的に遵守していることが強く求められています。

欧州委員会AIオフィスのガイダンスによれば、robots.txtなどの機械可読な拒否信号を無視して学習したモデルは、たとえ日本国内で合法に開発されていても、EU市場では問題視され得ます。

ここで重要なのは、EUでは著作権が「結果責任」ではなく「プロセス責任」として設計されている点です。何を生成したか以前に、どう学習したかが問われるのです。

この違いは、日本企業にとって実務上の大きな緊張関係を生みます。日本基準だけで構築した学習データパイプラインは、EUでは通用しない可能性が高く、データの分離管理やグローバル基準への統一が迫られます。

専門家の間では、日本法は「イノベーション促進型」、EU法は「権利者保護型」と整理されますが、2026年時点でグローバル展開を目指す生成AIは、より厳しいEU基準に引き寄せられているのが現実です。

生成AIと著作権の問題は、単なる法解釈ではなく、どの法域を前提にAIを設計するのかという経営判断そのものになりつつあります。

AIオフィスとは何者か:新たな規制司令塔の実像

EU AI法の実効性を左右する存在として、2025年から本格稼働したのがAIオフィスです。これは新たな規制当局というより、欧州全体のAIガバナンスを統合・指揮する司令塔として設計された組織です。欧州委員会の内部組織でありながら、加盟国当局や企業、研究者を横断的につなぐハブの役割を担っています。

最大の特徴は、汎用AIモデル、いわゆるGPAIに対する直接的な監督権限を持つ点です。従来のEU規制では、執行は各国当局に委ねられるケースが一般的でした。しかしAIオフィスは例外的に、GPAIに関する評価、指導、重大インシデントの受理を一元化しています。これは、基盤モデルが国境を越えて影響を及ぼす現実を踏まえた、極めて戦略的な設計です。

初代ディレクターに就任したルチッラ・シオリ氏は、長年デジタル政策を統括してきた実務家として知られています。CSISなどの政策分析機関によれば、彼女は規制一辺倒ではなく、イノベーションとの両立を重視する姿勢を明確にしており、日本企業にとっても対話の余地があるリーダーと評価されています。

| 機能領域 | AIオフィスの役割 | 企業への影響 |

|---|---|---|

| GPAI監督 | リスク分類と義務遵守の確認 | 基盤モデル提供者は直接対応が必要 |

| インシデント対応 | 重大事故の窓口を一元化 | 報告遅延が制裁リスクに直結 |

| 加盟国調整 | 各国当局の判断を統合 | 解釈のばらつきが減少 |

AIオフィスを技術面で支えるのが、独立専門家による科学パネルです。このパネルは、どのモデルがシステミックリスクを持つかを助言し、その意見書は規制判断の重要な根拠となります。Tech Policy Pressなどが指摘するように、政治的バランスと専門性の両立が図られた構成であり、純粋な技術評価だけでなく政策的判断が反映される点も見逃せません。

ガジェットやAIサービスを欧州市場で展開する企業にとって重要なのは、AIオフィスが単なる監視者ではない点です。実務規範の策定やAIパクトの運営を通じ、早期に対話した企業ほど運用面で有利な理解を得やすい構造になっています。規制を避ける対象ではなく、理解すべき相手としてAIオフィスを捉えることが、2026年以降の現実的な戦略と言えます。

自動車・エレクトロニクス分野への影響と現実的リスク

自動車およびエレクトロニクス分野は、EU AI法の中でも特に「現実的なリスク」が顕在化しやすい領域です。理由は明確で、これらの製品は人の生命・安全、プライバシー、基本的権利と直接結びつく用途が多く、AI法上の高リスク分類に該当しやすいためです。欧州委員会の整理によれば、自動運転や高度運転支援システム、監視カメラ、産業用ロボット、スマート家電に搭載されるAIは、単なるソフトウェアではなく「製品の安全コンポーネント」として評価されます。

自動車分野では、AI法と既存の車両型式認証制度が重なることによる実務負担が最大の懸念です。UNECE WP.29など国際基準に沿って開発してきた日本メーカーであっても、EU AI法ではデータガバナンス、人間による監視、ログ保存といった新たな要求が加わります。特に問題となるのが学習データです。走行データやドライバーモニタリング映像が個人データに該当する場合、GDPRとAI法の双方への適合が求められ、設計段階からの対応を誤ると欧州市場での販売停止という現実的リスクに直結します。

エレクトロニクス分野では、エッジAIの「目的の解釈」がリスクの分水嶺となります。JEITAが以前から指摘している通り、同じ顔認識技術であっても、セキュリティ目的か、生体認証か、感情認識かによって規制レベルが大きく異なります。欧州当局は技術そのものではなく、意図された用途を重視するため、日本側の製品仕様書やマーケティング表現が不十分だと、禁止または高リスクAIと判断される可能性があります。

| 分野 | 想定されるAI用途 | 現実的リスク |

|---|---|---|

| 自動車 | ADAS・自動運転 | 型式認証遅延、販売停止、リコール |

| 家電・センサー | 監視・見守りAI | 高リスク誤認定による制裁金 |

| 産業機器 | 協働ロボット | 安全評価不足による導入拒否 |

さらに見落とされがちなのが、サプライチェーン上の責任問題です。AI法では「自社ブランドで市場に置いた者」が原則としてプロバイダーとされますが、実際には日本の部品メーカーや半導体企業も、契約次第で責任の一部を負う可能性があります。欧州の法律事務所や規制当局の見解によれば、契約書にAI法対応の役割分担が明記されていない場合、想定外の責任追及を受けるリスクがあります。

重要なのは、これらのリスクが理論上の話ではなく、**開発スケジュールの遅延、追加コスト、欧州市場からの撤退判断**といった経営判断に直結する点です。デジタル・オムニバスによる実質的な延期は一定の救済策ですが、欧州委員会や専門家の多くは「今動かなかった企業ほど、後で高い代償を払う」と警鐘を鳴らしています。自動車・エレクトロニクス分野では、技術力そのものよりも、規制を読み解き、設計と文書に落とし込む力が競争力を左右する時代に入っています。

コンテンツ・ゲーム・クリエイティブ産業が直面する課題

コンテンツ・ゲーム・クリエイティブ産業は、EU AI法によって最も複雑な影響を受ける分野の一つです。理由は明確で、これらの産業が著作権で保護された創作物を中核資産としつつ、同時に生成AIを制作現場へ急速に取り込んでいるからです。**権利者として守る立場と、技術利用者として守られる側に立つ立場が同時に存在する**という構造的な緊張が、この分野特有の課題を生み出しています。

特に注目すべきは、AI生成コンテンツに対する透明性義務です。EU AI法第50条に基づき、ディープフェイクや合成コンテンツには、人間が生成したものではないと分かる表示が求められます。欧州委員会やAIオフィスの解釈によれば、この義務は広告や報道だけでなく、**ゲーム内で自動生成される背景アセットや、VTuber配信で用いられるリアルタイム合成技術**にも波及する可能性があります。ソニーや任天堂のように長い開発サイクルを持つ企業にとって、2027年2月までの猶予は重要ですが、実装負荷が消えるわけではありません。

さらに深刻なのが、生成AIの学習データを巡る著作権問題です。EUの著作権指令では、権利者がテキスト・データ・マイニングを拒否するオプトアウト権を明示的に認めています。欧州の学術研究や政策分析でも、AI開発企業がrobots.txtなどの機械可読な拒否シグナルを無視した場合、**モデルそのものが違法と判断されるリスク**があると指摘されています。日本の著作権法が比較的柔軟であることから、日本企業ほどこのギャップに戸惑いやすい状況です。

| 課題領域 | 具体的影響 | 実務上の論点 |

|---|---|---|

| 透明性義務 | AI生成物への表示対応 | 既存ゲームや配信技術への後付け実装 |

| 学習データ | IPの無断利用リスク | EU基準でのデータフィルタリング |

| ビジネスモデル | 制作効率と規制の衝突 | 生成AI活用範囲の再定義 |

欧州の研究機関や法学者によれば、今後の争点は「誰がAI生成物の最終的な責任主体なのか」という点に集約されるとされています。例えば、ゲームエンジン側が提供する生成機能と、開発スタジオが指定するプロンプトの関係性次第で、責任の所在が変わり得ます。これは単なる法務論ではなく、**契約設計や制作フローそのものを見直す経営課題**です。

結果として、コンテンツ・ゲーム・クリエイティブ産業は、AIを使うか使わないかという二択ではなく、**どこまでを人間の創作とし、どこからをAIに委ね、その境界をどう説明するか**という高度な戦略判断を迫られています。EU AI法は、この産業にとって単なる規制ではなく、創造性の価値を再定義する外圧として機能し始めているのです。

AIパクトに署名する日本企業の狙いと評価

EUのAIパクトに日本企業が署名する動きは、単なる規制順守の意思表示ではありません。最大の狙いは、EU AI法の解釈と運用が固まる前段階で、規制当局との対話チャネルを確保することにあります。AIパクトは法的拘束力を持たない自主誓約ですが、欧州委員会AIオフィスが主導し、参加企業をワークショップや非公開ブリーフィングに招く仕組みが組み込まれています。これは、完成前の実務規範やガイダンスの方向性を把握できる、事実上の先行情報アクセス権と評価されています。

NEC、富士通、日立製作所といった日本企業が早期に署名した背景には、EU AI法が典型的なブリュッセル効果を持つ点への強い認識があります。欧州委員会の公式資料によれば、AIパクトは「施行前からの実装準備を行う企業を可視化する」ことを目的としており、将来的な監督や対話において信頼の前提条件として参照される可能性が示唆されています。つまり、署名企業は規制違反を免除されるわけではないものの、誠実な対応主体として扱われる確率を高める戦略的選択だと言えます。

この姿勢は、米国巨大テックの一部が署名を見送った事例と対照的です。欧州の政策研究機関や法律事務所の分析では、メタやアップルの不参加は「法的リスクの最小化」を優先した判断とされる一方、日本企業は「長期的な市場信頼」を重視したと評価されています。特にB2B取引が中心となる日本企業にとって、欧州の公共調達や大企業との共同プロジェクトでは、AIガバナンス体制そのものが入札要件や評価項目に組み込まれつつあります。

| 観点 | 日本企業のAIパクト署名 | 署名を見送った企業の一般的傾向 |

|---|---|---|

| 規制当局との関係 | 早期から対話・協調を重視 | 正式ルール確定後に対応 |

| レピュテーション | 信頼性・誠実性を前面に訴求 | 技術力・市場支配力を優先 |

| 短期コスト | 内部体制整備の先行投資あり | 当面のコスト増を回避 |

専門家の間では、AIパクトは「ロビイングの新しい形」とも評されています。従来の陳情や意見提出ではなく、自社の実装状況やガバナンス体制を実例として示すことで、運用ルールの現実性に影響を与える手法だからです。AIオフィス関係者のコメントとしても、参加企業の実装事例がガイドライン策定の参考にされていることが示されています。

総合的に見ると、日本企業のAIパクト署名は、規制リスク低減と市場競争力強化を同時に狙った合理的な経営判断です。短期的には対応コストが発生しますが、欧州市場で「信頼できるAIベンダー」として認知されることは、中長期的な売上やパートナーリング機会に直結します。協調を重んじる日本企業の企業文化が、EUの価値観と高い親和性を持つ点も含め、AIパクト参加は2026年時点で概ねポジティブに評価されていると言えるでしょう。

ISO/IEC 42001が鍵を握る理由と実務的メリット

EU AI法への対応を考えるうえで、ISO/IEC 42001が鍵を握る最大の理由は、不透明な欧州規格の完成を待たずに、今すぐ着手できる唯一の国際的な実務基盤だからです。CEN/CENELECによる整合規格は遅延しており、企業は「守るべき法律はあるが、守り方が確定していない」状態に置かれています。その空白を埋めるのが、AIマネジメントシステムを体系化したISO/IEC 42001です。

この規格は、AIを個別技術ではなく経営システムとして管理する点に特徴があります。モデル単体の性能や精度ではなく、企画、設計、学習、運用、廃棄に至るまでのライフサイクル全体を対象とし、リスク評価、人間による監視、データガバナンス、インシデント対応を組織プロセスとして組み込みます。欧州委員会が示すAI法の基本思想である「Trustworthy AI」との親和性が高いと評価されている理由です。

実務的メリットとして特に大きいのが、将来の整合規格へのスムーズな接続です。欧州ではISO/IEC 42001をEN規格として採用し、Annex ZでAI法固有の要求事項を補完する方向で調整が進んでいます。つまり、今42001に準拠しておけば、後から欧州独自要件が追加されても、ゼロから作り直す必要がありません。欧州委員会の標準化文書でも、国際規格を基盤とするアプローチが現実解として示されています。

| 観点 | ISO/IEC 42001準拠の効果 | EU AI法との関係 |

|---|---|---|

| リスク管理 | AIリスクを組織的に特定・低減 | 高リスクAIの要求事項と整合 |

| ガバナンス | 責任者・意思決定プロセスを明確化 | Human Oversight義務に対応 |

| 監査対応 | 文書化された証跡を常時保持 | 市場監視当局への説明責任を補強 |

さらに、日本企業にとって見逃せないのが社内外への説明力です。AIパクトに署名する企業が増える中、単なる宣言ではなく、第三者認証や準拠実績を伴う42001は、欧州の取引先や規制当局に対する説得力を大きく高めます。実際、ソニーグループなどはAI倫理ガイドラインを品質管理システムに統合し、42001を見据えた体制整備を進めています。

専門家の間では、「ISO/IEC 42001はEU AI法への保険ではなく、競争力の源泉になる」との見方が共有されています。規制対応をコストで終わらせるのか、信頼できるAIを提供できる組織能力として資産化するのか。その分岐点において、42001は日本企業が持つ品質管理の強みを、AI時代に翻訳するための最短ルートとなります。

日本企業・開発者のための実践的コンプライアンス思考

日本企業・開発者にとってEU AI法対応で最も重要なのは、条文解釈そのものよりも、日常の開発・運用プロセスにどう落とし込むかという実践的コンプライアンス思考です。特に日本では、技術部門と法務・コンプライアンス部門が分断されがちですが、EU AI法はその分断を前提にしていません。設計・学習・提供・運用の全工程が一続きの責任として評価される点を、まず開発現場が理解する必要があります。

欧州委員会AIオフィスの説明によれば、違反リスクの多くは「悪意」ではなく「想定不足」から生じています。例えば、国内向けに開発したAI機能をそのまま欧州向け製品に転用し、意図せず高リスク用途に該当してしまうケースです。日本のエンジニア文化では汎用性や再利用性が美徳とされますが、EUの規制文脈では「意図された利用目的」の明確化が最優先されます。

この思考転換を支えるため、多くの先進企業は開発初期段階から簡易的なリスク整理シートを導入しています。ISO/IEC 42001や欧州標準化文書のドラフトでも、ライフサイクル全体での記録保持が強調されています。開発メモや設計判断の背景を残す行為は、日本では属人的になりがちですが、EUでは将来の監督当局への説明責任を果たすための重要な証拠となります。

| 開発フェーズ | 日本的な慣行 | EU AI法対応での視点 |

|---|---|---|

| 企画・要件定義 | 機能・性能中心 | 利用目的と影響範囲の明文化 |

| 学習・検証 | 精度・速度重視 | データ出所と偏りの説明可能性 |

| 提供・運用 | 障害対応中心 | 想定外利用への予防策と記録 |

また、日本企業が見落としやすいのが、ファインチューニングや設定変更といった「軽微な改変」の扱いです。欧州委員会のガイドラインでは、これらがリスクプロファイルを変える場合、新たな提供者責任が生じ得ると明示されています。自社は単なる利用者だという認識は、EUでは通用しない場合があることを、開発者自身が理解しておく必要があります。

実践的なコンプライアンス思考とは、規制を恐れて手を止めることではありません。むしろ、JEITAや広島AIプロセスで培われた人間中心・品質重視の思想を、EUが理解できる形で翻訳する作業です。日本企業が得意とする改善活動や品質管理を、文書化と説明責任という形で補強できれば、EU AI法対応は単なる負担ではなく、信頼を獲得する競争力へと転換していきます。

参考文献

- European Commission:Timeline for the Implementation of the EU AI Act

- Sidley Austin LLP:EU Digital Omnibus: The European Commission Proposes Important Changes to the EU’s Digital Rulebook

- European Commission:AI Pact

- European Union – Shaping Europe’s digital future:The General-Purpose AI Code of Practice

- Fujitsu:Fujitsu Kozuchi AI technologies assist AKOS AI in delivering solutions for EU AI compliance

- Tech Policy Press:Europe’s Advanced AI Strategy Depends on a Scientific Panel. Who Will Make the Cut?